Kada govorimo o troškovima AI infrastrukture, fokus obično pada na Nvidiju i GPU-ove, međutim, memorija postaje sve važniji faktor. Dok se veliki igrači pripremaju izgraditi nove podatkovne centre vrijedne milijarde dolara, cijena DRAM čipova je u posljednjih godinu dana porasla otprilike 7 puta.

Istovremeno, raste disciplina u orchestraciji te memorije kako bi se osiguralo da pravi podaci dođu do pravog agenta u pravom trenutku. Tvrtke koje to savladaju moći će postavljati iste upite s manje tokena, što može biti razlika između propasti i opstanka na tržištu.

Analitičar poluvodiča Doug O’Laughlin pruža zanimljiv uvid u važnost memorijskih čipova na svom Substacku, gdje razgovara s Valom Bercoviciem, glavnim AI službenikom u Weki. Obojica su stručnjaci za poluvodiče, pa je fokus više na čipovima nego na širem okviru; implikacije za AI softver su također značajne.

Posebno me zaintrigirao ovaj odlomak u kojem Bercovici gleda na rastuću složenost dokumentacije za predmemoriranje od Anthropic-a:

Indikator je ako odemo na stranicu s cijenama predmemoriranja Anthropic-a. Prvo je to bila vrlo jednostavna stranica prije šest ili sedam mjeseci, posebno kada se pokrenuo Claude Code — samo „koristite predmemoriju, to je jeftinije“. Sada je to enciklopedija savjeta o tome koliko predmemorijskih upisa unaprijed kupiti. Imate 5-minutne razrede, koji su vrlo uobičajeni u industriji, ili 1-satne razrede — i ništa iznad toga. To je zaista važan indikator. Naravno, imate i razne arbitražne prilike oko cijena za čitanje iz predmemorije na temelju broja unaprijed kupljenih predmemorijskih upisa.

Pitanje ovdje je koliko dugo Claude drži vaš upit u predmemoriji: Možete platiti za 5-minutno razdoblje ili više platiti za satno razdoblje. Mnogo je jeftinije koristiti podatke koji su još u predmemoriji, pa ako to dobro upravljate, možete uštedjeti značajno. No, postoji caka: Svaki novi bit podataka koji dodate upitu može izbaciti nešto drugo iz predmemorije.

Ovo je složena tematika, no zaključak je dovoljno jednostavan: Upravljanje memorijom u AI modelima bit će ključni faktor u budućnosti AI-a. Tvrtke koje to rade dobro će se istaknuti.

Postoji mnogo napretka koji se može postići u ovom novom području. U listopadu sam pisao o startupu pod nazivom Tensormesh koji radi na jednoj razini u strukturi poznatoj kao optimizacija predmemorije.

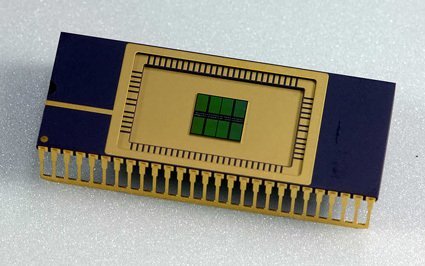

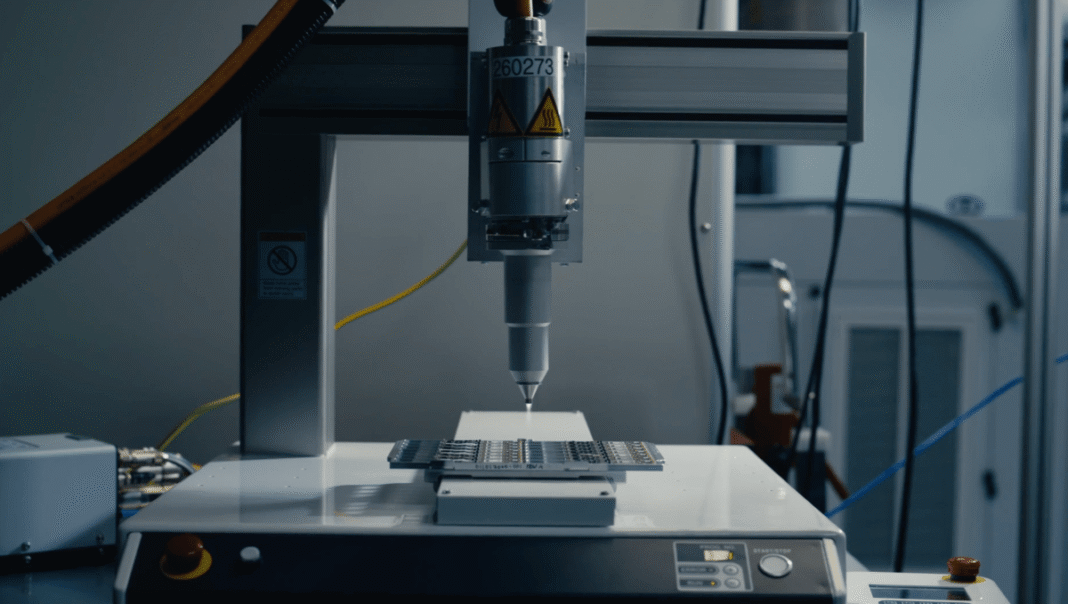

Prilike postoje i na drugim dijelovima strukture. Na primjer, niže u strukturi, postavlja se pitanje kako podatkovni centri koriste različite vrste memorije koju imaju. (Intervju uključuje dobru raspravu o tome kada se DRAM čipovi koriste umjesto HBM-a, iako je to prilično duboko u tehničkim detaljima.) Više u strukturi, krajnji korisnici otkrivaju kako strukturirati svoje modelne skupine kako bi iskoristili zajedničku predmemoriju.

Kada tvrtke postanu bolje u orchestraciji memorije, koristiti će manje tokena, a inferencija će postati jeftinija. U međuvremenu, modeli postaju učinkovitiji u obradi svakog tokena, što dodatno smanjuje troškove. Kako troškovi poslužitelja opadaju, mnogo aplikacija koje se sada ne čine održivima počet će se približavati profitabilnosti.